實戰教學:如何建立一套 1 小時內完成的「超高效 AI 短片工作流」

對唔少創作者嚟講,製作 AI 短片最大嘅兩個痛點,從來都唔係「冇工具」,而係:

角色風格無法保持一致

畫面質感同完成度難以控制

結果就係:時間花咗,但成品仍然似「半成品 demo」。

呢篇文章會完整拆解一套經過實戰驗證嘅 5 步驟 AI 短片工作流,將原本需要幾日甚至一個團隊先做到嘅事,壓縮到幾個鐘內完成,同時保持角色一致、畫面穩定、流程可複製。

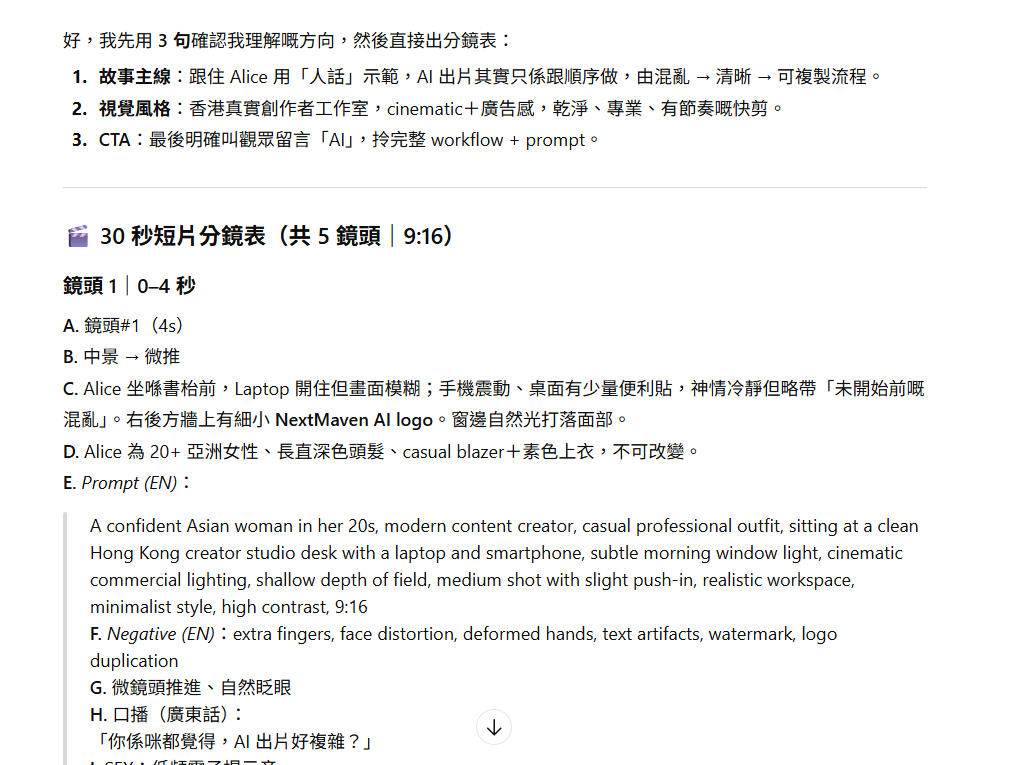

Step 1:AI 超級編劇——由想法到「可執行」分鏡

一條高完成度嘅短片,關鍵唔係靈感,而係一份可以直接落手做嘅分鏡劇本。

最大嘅錯誤示範係:「幫我寫一條 AI 短片故事」

呢類模糊指令,只會換嚟一堆用唔到嘅文字。

正確做法係:一開始就要求 AI 以「分鏡腳本(Shot List)」格式輸出,而唔係普通文章。

分鏡一定要包含三個元素:

畫面描述:清楚定義角色、場景同視覺重點

鏡頭語言:景別(特寫 / 中景 / 全景)同節奏

口播稿:每鏡一段可直接配音嘅台詞(約 5–8 秒)

👉 資源:Template 1|AI 超級編劇 Prompt

(複製以下提示詞,填入你的故事概念:)

你係專業短片導演兼編劇。請把我嘅故事概念,轉成 45–60 秒短片分鏡劇本。

輸出格式要包含:

1) 一句 Logline

2) 3秒 Hook / 20秒 Wrong vs Right / 7秒 CTA 的節奏

3) Shot list(最少 8 個 shot),每個 shot 包含:

- 場景

- 景別(特寫 / 近景 / 中景 / 全景)

- 鏡頭角度(平視 / 俯拍 / 仰拍)

- 角色動作與表情

- 重要道具或畫面文字

- 畫面風格關鍵詞

- 對白(如有)

限制:每個 shot 3–5 秒;鏡頭需可剪接、連貫。

我的故事概念是:{貼上你的概念}

目標觀眾:香港/廣東話觀眾;語氣自然、節奏明快。

完成呢一步,你手上已經唔係「想法」,而係一份可直接交畀 AI 執行嘅藍圖。

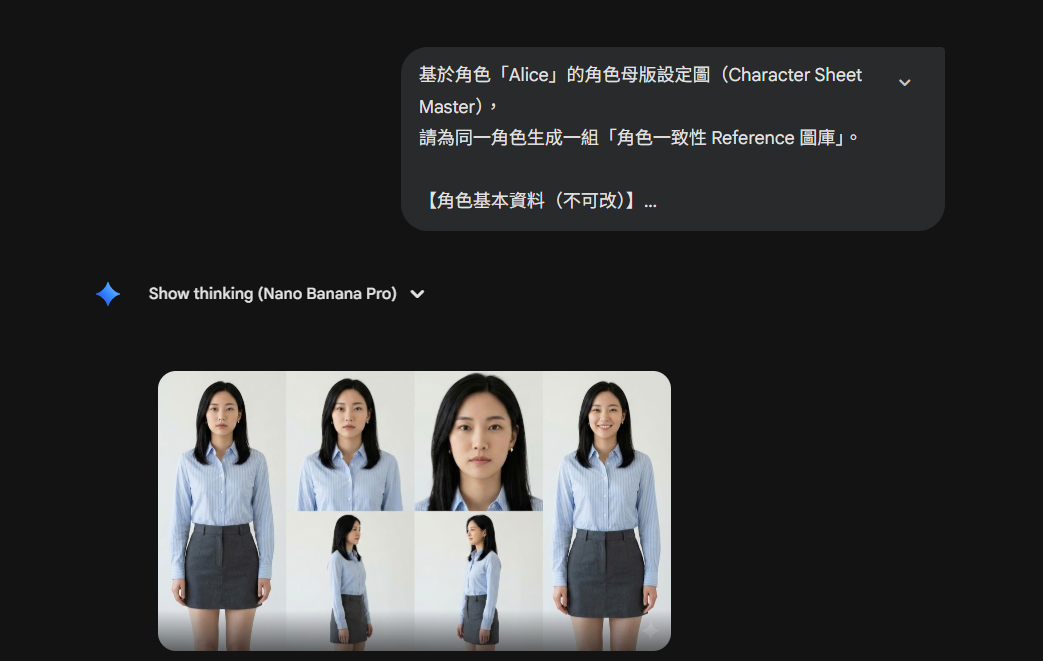

Step 2: 角色一致性設定(Character Consistency)

九成 AI 短片失敗,唔係畫面唔靚,而係——

角色一鏡一樣,完全唔似同一個人。

解法係:幫角色建立一張「角色身份證(Character Sheet)」。

核心原則:先分清「邊啲可以變,邊啲一定唔可以變」

不可變元素(必須鎖死):

- 臉型與五官比例

- 膚色、髮型方向

- 年齡感、氣質

- 固定服裝顏色或標誌性配件

可變元素(允許變動):

- 表情、姿勢

- 場景、鏡頭角度

- 光影、情緒狀態

Reference 圖庫建議

準備最少 6 張角色參考圖:

- 正面

- 左側

- 右側

- 半身

- 全身

- 自然微笑

工具方面,可以用 Nano Banana Pro 或同類方案,透過「母版角色圖 + Reference 圖」去做一致性鎖定,唔需要一開始就訓練模型。

👉 資源:Template 2|角色身份證 Prompt

請為我建立一份「角色身份證」,分成不可變元素與可變元素。

不可變元素要描述到可以用作一致性錨點(五官比例、髮型方向、氣質、標誌性配件)。

可變元素列出允許變動(服裝、背景、姿勢、情緒、鏡頭)。

最後輸出 1 段「一致性錨點描述」(80–120字),方便我每次生成都貼上。

角色概念:{角色設定}

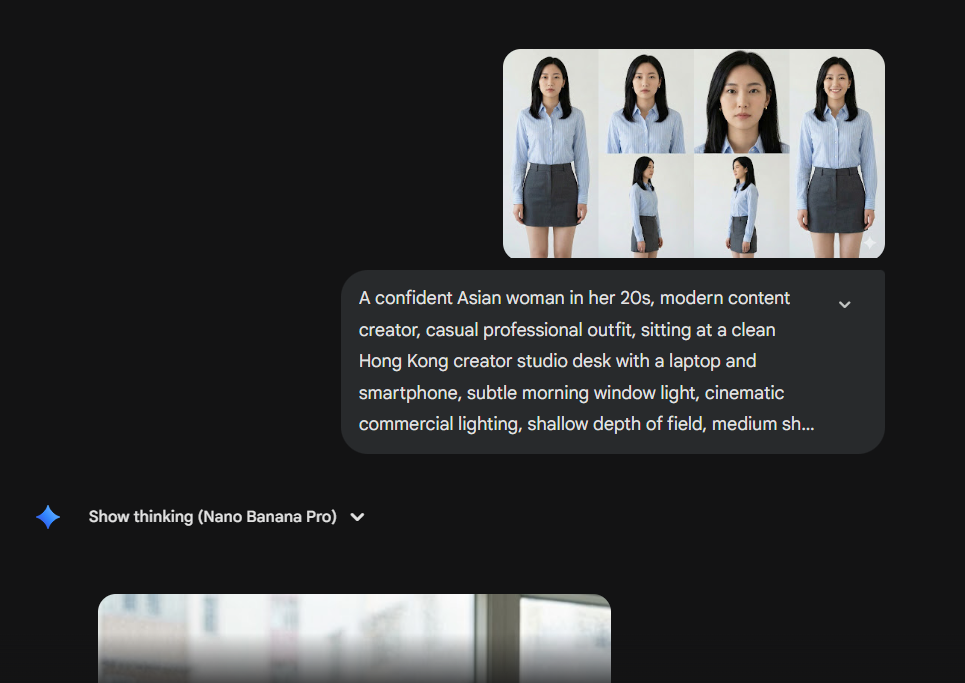

Step 3: 生成電影級畫面(先圖後片)

如果你直接用文字生成影片(Text-to-Video),結果大多數都係——不可控。

更穩定嘅做法係:

兩步法:先文生圖,再圖生影片

1. 文生圖(Text-to-Image)

用 Step 1 嘅畫面描述

加 Step 2 已鎖死嘅角色 Reference

為每個分鏡生成一張靜態 Keyframe

好處係:你可以喺「靜態階段」完全掌控構圖、光影、服裝細節,而唔係交畀 AI 抽獎。

2. 圖生影片(Image-to-Video)

將滿意嘅 Keyframe 作為起始畫面

用 Kling(可靈)等工具

只加入少量、可控嘅動態指令

👉 資源:Template 3|鏡頭生成 Shot Prompt

根據以下角色一致性錨點與鏡頭要求,生成一個單一鏡頭畫面描述(可用於 image 或 image-to-video)。

一致性錨點:{貼上錨點}

鏡頭編號:{S01_SH03}

場景:{辦公室/街頭/咖啡店...}

景別與角度:{近景/平視...}

動作:{角色做咩}

情緒:{緊張/自信...}

風格:{寫實/動畫/電影感...}

限制:不要改變角色五官比例與標誌性配件;畫面內文字要少且清晰(如需要)。

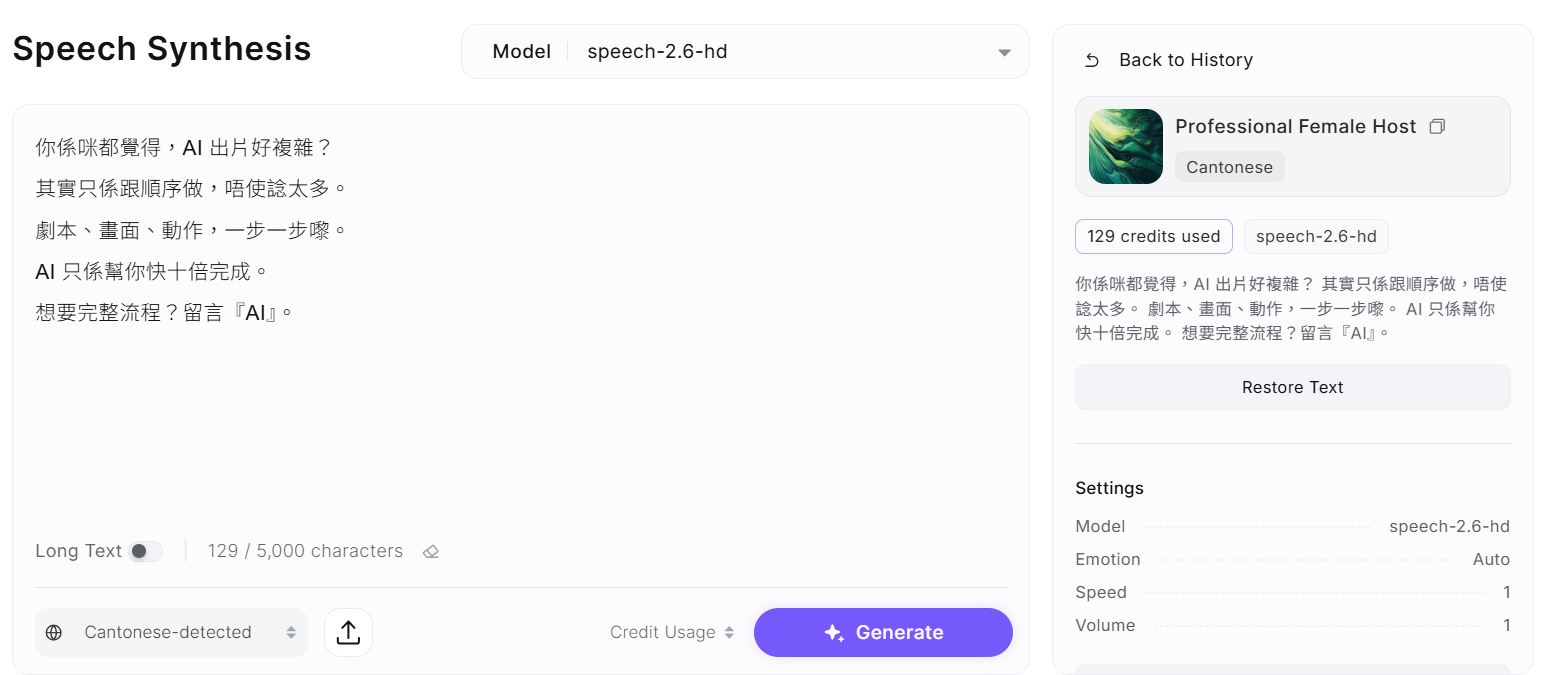

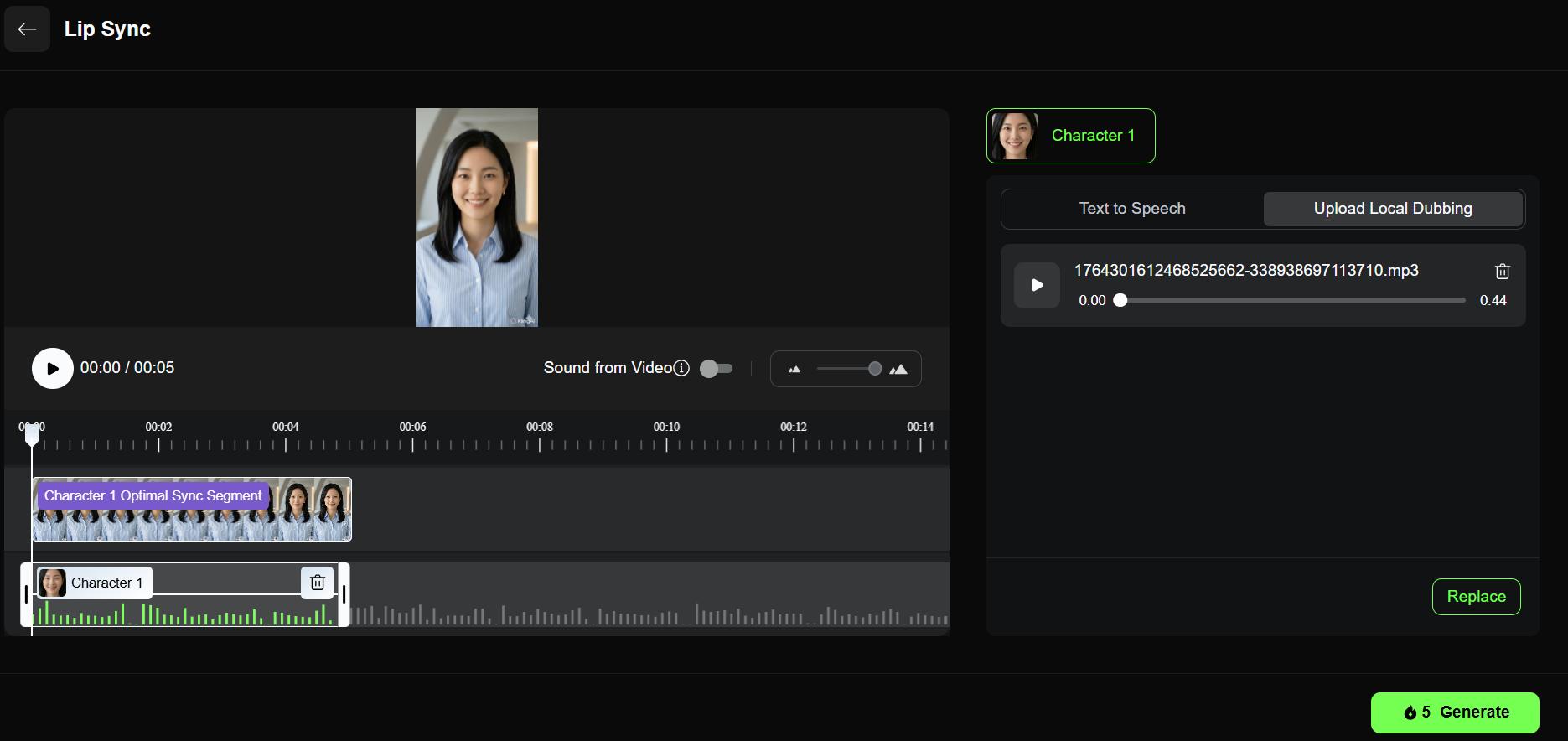

Step 4: AI 配音與口型同步(Lip Sync)

畫面完成後,最大破綻通常出現在兩樣嘢:聲音同口型。

操作流程

1. AI 配音

使用 Minimax 等工具

直接將分鏡口播稿轉成廣東話旁白

2. 口型同步(只揀必要鏡頭)

只處理真正需要開口嘅特寫鏡頭

用 Kling 嘅 Lip Sync 功能

AI 會自動分析音頻,驅動嘴部動作

👉 資源:Template 4|Lip Sync 專用 Prompt

請把以下對白改寫成「適合口型」的廣東話口語稿:

- 句子短

- 每句 8–12 字左右

- 加入自然停頓(用「…」表示)

- 情緒標記(括號內:冷靜/興奮/無奈)

原對白:{貼上}

Step 5: AI 剪輯加速與整合

去到最後一步,其實已經冇乜技術難度。

你手上已經有:

角色一致嘅影片片段

對好口型嘅鏡頭

完整旁白音檔

推薦工具:剪映(JianYing)或 CapCut

建議流程

將影片與音檔拉入 Timeline

加入免版稅 BGM

字幕建議手動調整:控制大小、節奏同重點,效果會好過全自動字幕

總結:真正嘅關鍵係「控制力」

呢套流程嘅核心唔係用咗幾多 AI 工具,而係:

你每一步,都知道自己喺控制乜。

透過結構化 Prompt + 分階段生成(先圖後片),

你唔再係被 AI 隨機性牽住走,而係好似導演一樣,清楚決定:

觀眾應該睇到乜

聽到乜

最後記住乜

而家,就直接複製以上 Prompt,開始製作你第一條真正有完成度嘅 AI 短片。

探索全新部落格文章

隨時掌握我們的最新文章

.png)

.png)

.png)

.png)

.png)